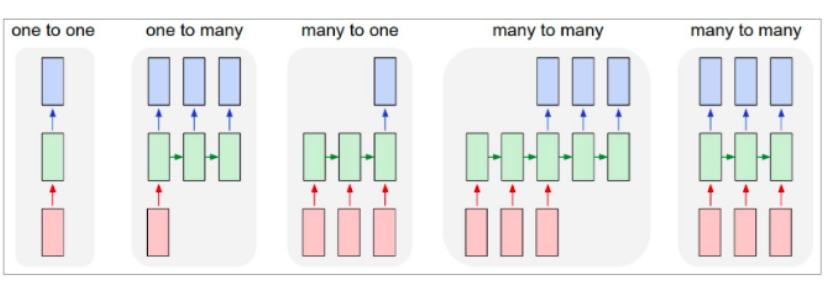

為了解決RNN梯度消失的問題,於是衍伸出LSTM,LSTM 一樣是把相同的結構重複,也就是 RNN Recurrent 的概念, LSTM 與 RNN 相似,能處理不同長度的 input 並轉換成同樣長度的 hidden state ,這些 hidden state 就可以再進一步的做各種運算,像是語言模型預測下一個詞、或是句子的翻譯等等。

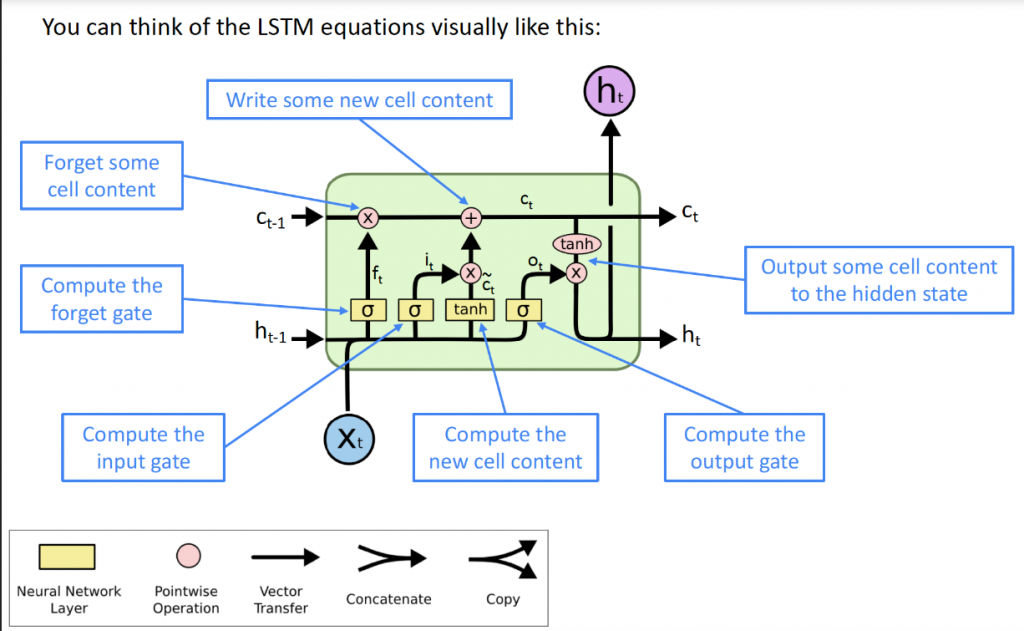

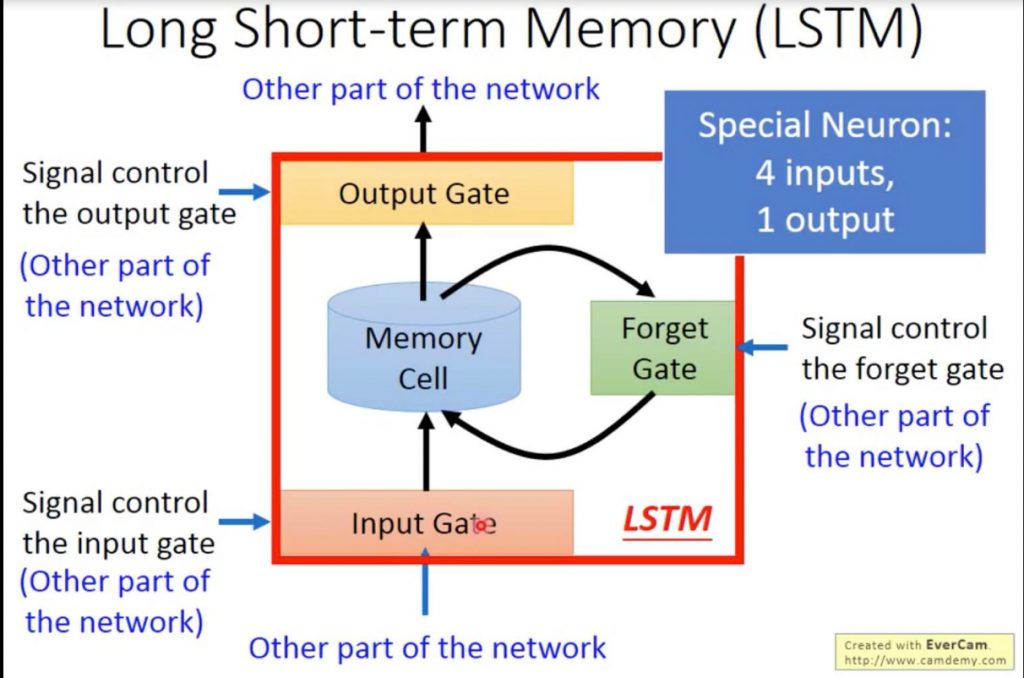

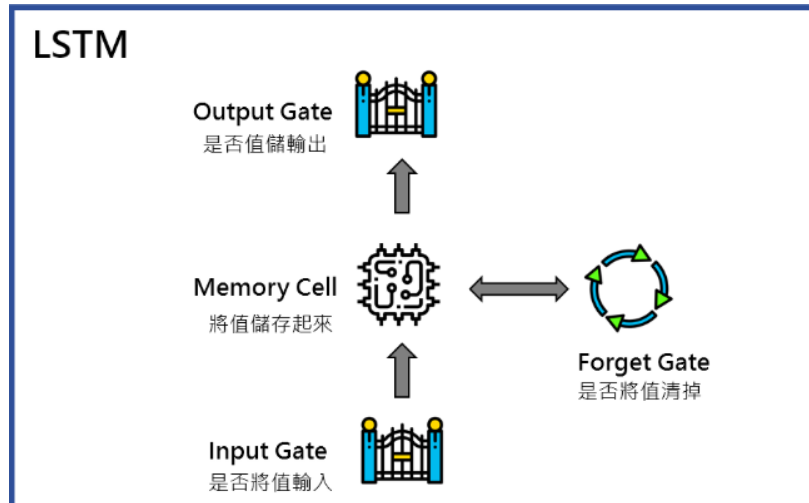

LSTM由四個unit組成: Input Gate、Output Gate、Memory Cell以及Forget Gate。

http://karpathy.github.io/2015/05/21/rnn-effectiveness/